◆ 2022/4Q (10/01/2022 〜 12/20/2022)

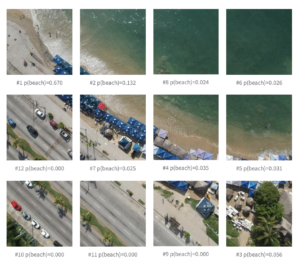

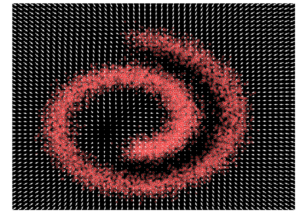

HuggingFace ブログ : 遠隔センシング (衛星) 画像とキャプションによる CLIP の微調整

この記事は、Hugging Face の Flax/JAX Community Week イベントのプロジェクトの一つを紹介しています。

OpenAI の CLIP ネットワーク を RSICD データセットの衛星画像とキャプションで再調整し、その性能を評価しています。

[詳細] (12/20/2022)

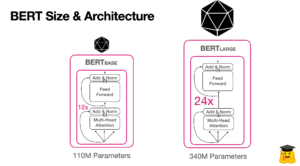

HuggingFace ブログ : BERT 101 🤗 最先端 NLPモデルの解説

この記事では、BERT とは何か、何故それは違うのか、そして BERT でどのように始めるかを学習します。

BERT (Transformers による双方向エンコーダ表現) は自然言語処理のための機械学習モデルです。それは 2018 年に Google AI 言語の研究者により開発され、センチメント分析や固有表現抽出のような最も一般的な言語タスクの 11+ へのスイスアーミーナイフな解法として機能しています。

[詳細] (12/19/2022)

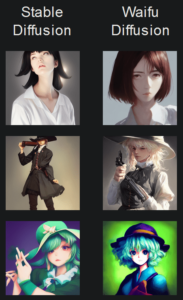

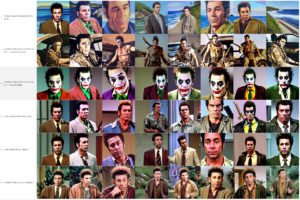

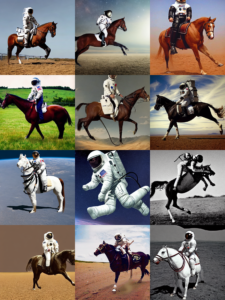

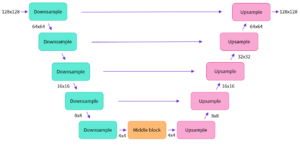

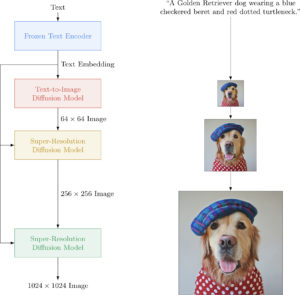

Stable Diffusion Version 2 : 概要

大人気のテキスト-to-画像変換拡散モデル Stable Diffusion の Version 2.1 が今月公開されましたので、ドキュメントを翻訳しておきます。

768×768 解像度 (Stable Diffusion 2.1-v) と 512×512 解像度 (Stable Diffusion 2.1-base) の新しい stable diffusion モデルで、両方とも 2.0 と同じ数のパラメータとアーキテクチャに基づき、LAION-5B データセットのより制限の少ない NSFW フィルタリングにより 2.0 上で微調整されています。

[詳細] (12/19/2022)

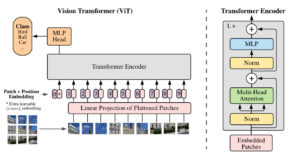

HuggingFace ブログ : 画像分類用 ViT (Vision Transformer) の微調整

この記事は 🤗 transformers で事前訓練済み ViT (Vision Transformer) を微調整する方法を説明しています。

transformers ベースのモデルが NLP に変革をもたらしたように、現在では他のあらゆるドメインに適用した論文の爆発的な増加を引き起こしています。これらの最も画期的な一つが Google Brain 研究者チームにより 2021年6月に紹介されVision Transformer (ViT) です。

[詳細] (12/16/2022)

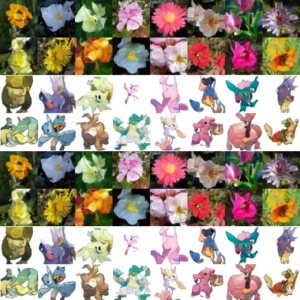

Paella (Novel テキスト-to-画像モデル) : ノートブック : サンプリング

Paella の各種サンプリングをノートブックで実演します。テキスト条件付き、マルチ条件付き、潜在空間補間、更にはインペインティング、アウトペインティングや構造的モーフィングも実演します。

Paella は高速なテキスト-to-画像モデルです。573M パラメータを持ちながら 500 ms 以下で単一画像をサンプリングすることを可能にする、速度に最適化されたアーキテクチャを使用しています。高忠実度な画像をサンプリングするのに 10 ステップ以下しか必要としない新規のテキスト-to-画像モデルです。

[詳細] (12/15/2022)

Paella (Novel テキスト-to-画像モデル) : 概要

Paella は高速なテキスト-to-画像モデルです。573M パラメータを持ちながら 500 ms 以下で単一画像をサンプリングすることを可能にする、速度に最適化されたアーキテクチャを使用しています。高忠実度な画像をサンプリングするのに 10 ステップ以下しか必要としない新規のテキスト-to-画像モデルです。

[詳細] (12/11/2022)

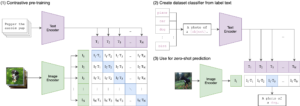

OpenCLIP 2.7 : ノートブック : OpenCLIP との相互作用

オリジナル CLIP との互換性を確認するためにノートブックを実行しています。OpenCLIP モデルをダウンロードして実行する方法、任意の画像とテキスト入力の間の類以度を計算する方法、そしてゼロショット画像分類を実行する方法を実演します。

CLIP (対照的言語-画像事前訓練) は様々な (画像, テキスト) ペアで訓練されたニューラルネットワークです。オリジナル実装は PyTorch で OpenAI により公開されました。

[詳細] (12/13/2022)

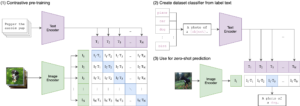

OpenCLIP 2.7 (CLIP オープンソース実装) : 概要

OpenCLIP は OpenAI の CLIP (対照的言語-画像事前訓練) のオープンソース実装です。

目標は対照的画像-テキスト supervision によるモデルの訓練を可能にし、分布シフトへの堅牢性のような特性を調査することです。出発点は同じデータセットで訓練するときオリジナルの CLIP モデルの精度に一致する CLIP の実装です。

オリジナルの CLIP は様々な (画像, テキスト) ペアで訓練されたニューラルネットワークです。オリジナル実装は PyTorch で OpenAI により公開されました。

[詳細] (12/13/2022)

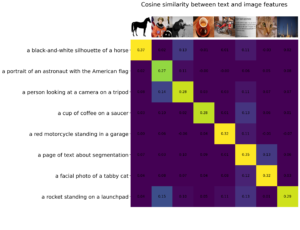

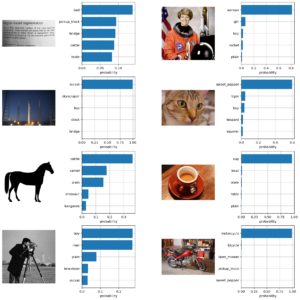

CLIP (対照的言語-画像事前訓練) : ノートブック : CLIP との相互作用

これは自己完結型のノートブックで、CLIP モデルをダウンロードして実行する方法、任意の画像とテキスト入力の間の類以度を計算する方法、そしてゼロショット画像分類を実行する方法を実演します。

CLIP (対照的言語-画像事前訓練) は様々な (画像, テキスト) ペアで訓練されたニューラルネットワークです。オリジナル実装は PyTorch で OpenAI により公開されました。

[詳細] (12/09/2022)

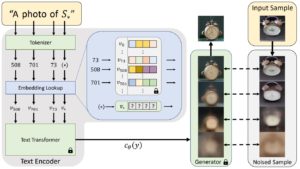

CLIP (対照的言語-画像事前訓練) : 概要

CLIP (対照的言語-画像事前訓練) は様々な (画像, テキスト) ペアで訓練されたニューラルネットワークです。オリジナル実装は PyTorch で OpenAI により公開されました。

GPT-2 と 3 のゼロショット機能と同様にタスクに対して直接最適化されることなく、画像が与えられたとき最も関連性の高いテキストのスニペットを予測するように自然言語で指示できます。

[詳細] (12/09/2022)

HuggingFace ブログ : Sentence Transformers モデルの訓練と微調整

Sentence Transformer モデルの訓練や再調整は利用可能なデータとターゲットタスクに極度に依存します。キーは 2 つから成ります : (1) データをモデルに入力する方法を理解してそれに応じてデータセットを準備します。(2) 様々な損失関数とそれらがデータセットとどのように関係するかを知ります。

[詳細] (12/08/2022)

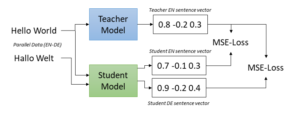

Sentence Transformers 2.2 : 訓練 : 多言語モデル

今回は訓練の「多言語モデル」です。論文「知識蒸留を使用した単一言語センテンス埋め込みの多言語化」で、センテンス埋め込みをより多くの言語に拡張する簡単なアプローチを記述しています。

Sentence Transformers は PyTorch エコシステムの一つで、センテンス、パラグラフや画像に対する密ベクトル表現を計算する簡単な方法を提供するフレームワークです。

[詳細] (12/06/2022)

Sentence Transformers 2.2 : 訓練 : 概要

今回は訓練の「概要」です。SentenceTransformers は貴方自身のセンテンス / テキスト埋め込みモデルを微調整することを簡単にするように設計されています。

Sentence Transformers は PyTorch エコシステムの一つで、センテンス、パラグラフや画像に対する密ベクトル表現を計算する簡単な方法を提供するフレームワークです。

[詳細] (12/04/2022)

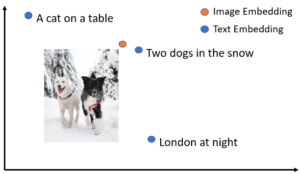

Sentence Transformers 2.2 : ノートブック : 画像検索 – (多言語) ゼロショット画像分類

今回はノートブックの「画像検索」から「(多言語) ゼロショット画像分類」です。このサンプルは SentenceTransformer が画像とテキストを同じベクトル空間にマップするためにどのように使用できるかを示します。ラベルのための名前を提供することによりこれをゼロショット分類を実行するために使用できます。

Sentence Transformers は PyTorch エコシステムの一つで、センテンス、パラグラフや画像に対する密ベクトル表現を計算する簡単な方法を提供するフレームワークです。

[詳細] (12/04/2022)

Sentence Transformers 2.2 : ノートブック : 画像検索 – 重複した画像 (重複画像の除去)

今回はノートブックの「画像検索」から「重複した画像」です。このサンプルは SentenceTransformer が画像の重複やそれに近いものを見つけるためにどのように使用できるかを示します。

Sentence Transformers は PyTorch エコシステムの一つで、センテンス、パラグラフや画像に対する密ベクトル表現を計算する簡単な方法を提供するフレームワークです。

[詳細] (12/02/2022)

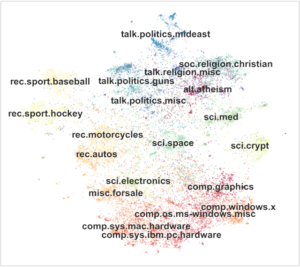

Sentence Transformers 2.2 : ノートブック : 画像検索 – 画像クラスタリング

今回はノートブックの「画像検索」から「画像クラスタリング」です。このサンプルは SentenceTransformer が画像クラスタリングのためにどのように使用できるかを示します。

Sentence Transformers は PyTorch エコシステムの一つで、センテンス、パラグラフや画像に対する密ベクトル表現を計算する簡単な方法を提供するフレームワークです。

[詳細] (12/01/2022)

次世代 PyTorch 2.0 : Get Started (要約と概要)

PyTorch 1.0 はここ数年で最新の 1.13 まで革新を繰り返し、Linux Foundation の一部として新たに設立された PyTorch Foundation に移行していますが、ついに PyTorch 2.0 が発表されました。

PyTorch の次世代 2 シリーズのリリースに向けての最初のステップとして (PyTorch 2.0 の発表とカンファレンスを補足するため、) Getting Started のドキュメントとその概要が公開されましたので、概要を翻訳しました。

[詳細] (12/03/2022)

Sentence Transformers 2.2 : ノートブック : 画像検索 – 画像 & 多言語テキストの結合埋め込み

今回はノートブックの「画像検索」から「画像 & 多言語テキストの結合埋め込み」です。オリジナルの CLIP モデルは英語に対してだけ動作するので、このモデルを 50+ 言語で動作するように多言語知識蒸留を使用しました。

Sentence Transformers は PyTorch エコシステムの一つで、センテンス、パラグラフや画像に対する密ベクトル表現を計算する簡単な方法を提供するフレームワークです。

[詳細] (11/29/2022)

Sentence Transformers 2.2 : ノートブック : 画像検索 – 画像 & テキストの結合埋め込み

今回はノートブックの「画像検索」から「画像 & テキストの結合埋め込み」です。SentenceTransformer が画像とテキストを同じベクトル空間にマップするためにどのように使用できるかを示します。

Sentence Transformers は PyTorch エコシステムの一つで、センテンス、パラグラフや画像に対する密ベクトル表現を計算する簡単な方法を提供するフレームワークです。

[詳細] (11/29/2022)

Sentence Transformers 2.2 : 使用方法 : 画像検索

今回は「使用方法」から「画像検索」です。SentenceTransformers は画像とテキストを同じベクトル空間に埋め込みことを可能にするモデルを提供しています。これは類似の画像を見つけて 画像検索 を実装することを可能にします。

Sentence Transformers は PyTorch エコシステムの一つで、センテンス、パラグラフや画像に対する密ベクトル表現を計算する簡単な方法を提供するフレームワークです。

[詳細] (11/29/2022)

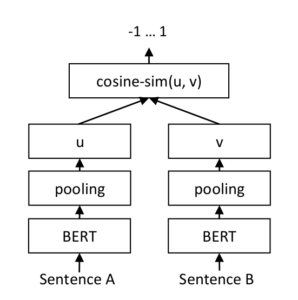

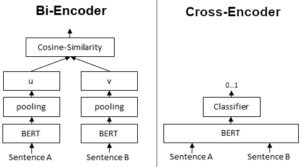

Sentence Transformers 2.2 : 使用方法 : 交差エンコーダ

今回は「使用方法」から「交差エンコーダ」です。SentenceTransformers はセンテンスペア・スコアリングとセンテンスペア分類タスクのための交差エンコーダのロードもサポートしています。

Sentence Transformers は PyTorch エコシステムの一つで、センテンス、パラグラフや画像に対する密ベクトル表現を計算する簡単な方法を提供するフレームワークです。様々なユースケースに対して調整された 100 言語以上の最先端の事前訓練済みモデルを提供しています。

[詳細] (11/28/2022)

Sentence Transformers 2.2 : 使用方法 : クラスタリング

今回は「使用方法」から「クラスタリング」です。Sentence-Transformers はセンテンスの小さなあるいは大きなセットのクラスタリングを実行するために様々な方法で利用できます。

Sentence Transformers は PyTorch エコシステムの一つで、センテンス、パラグラフや画像に対する密ベクトル表現を計算する簡単な方法を提供するフレームワークです。様々なユースケースに対して調整された 100 言語以上の最先端の事前訓練済みモデルを提供しています。

[詳細] (11/27/2022)

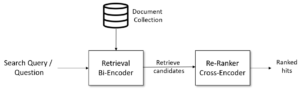

Sentence Transformers 2.2 : 使用方法 : 検索 & 再ランク付け

今回は「使用方法」から「検索 & 再ランク付け」です。意味検索では、クエリー、センテンスとパラフラフに対する埋め込みを計算するために SentenceTransformer を使用する方法と、これを意味検索に使用する方法を示しました。複雑な検索タスク、例えば、質問回答検索に対しては、検索は「検索 & 再ランク付け (Retrieve & Re-Rank)」を使用して大幅に改良できます。

Sentence Transformers は PyTorch エコシステムの一つで、センテンス、パラグラフや画像に対する密ベクトル表現を計算する簡単な方法を提供するフレームワークです。様々なユースケースに対して調整された 100 言語以上の最先端の事前訓練済みモデルを提供しています。

[詳細] (11/27/2022)

Sentence Transformers 2.2 : 使用方法 : 意味検索

今回は「使用方法」から「意味検索」です。意味検索は検索クエリの内容を理解することにより検索精度を改良します。語彙の一致に基づいてドキュメントを検索するだけの従来の検索エンジンとは対照的に、意味検索は同義語も見つけることができます。

Sentence Transformers は PyTorch エコシステムの一つで、センテンス、パラグラフや画像に対する密ベクトル表現を計算する簡単な方法を提供するフレームワークです。様々なユースケースに対して調整された 100 言語以上の最先端の事前訓練済みモデルを提供しています。

[詳細] (11/26/2022)

Sentence Transformers 2.2 : 使用方法 : 意味的テキスト類似性

今回は「使用方法」から「意味的テキスト類似性」です。センテンス埋め込みを計算したら、それらを互いに比較することを通常は望みます。ここでは埋め込み間のコサイン類似度を計算する方法を示します。例えば 2 つのテキストの意味的類似度を測ります。

Sentence Transformers は PyTorch エコシステムの一つで、センテンス、パラグラフや画像に対する密ベクトル表現を計算する簡単な方法を提供するフレームワークです。様々なユースケースに対して調整された 100 言語以上の最先端の事前訓練済みモデルを提供しています。

[詳細] (11/25/2022)

Sentence Transformers 2.2 : 使用方法 : センテンス埋め込みの計算

Sentence Transformers は PyTorch エコシステムの一つで、センテンス、パラグラフや画像に対する密ベクトル表現を計算する簡単な方法を提供するフレームワークです。様々なユースケースに対して調整された 100 言語以上の最先端の事前訓練済みモデルを提供しています。

今回は「使用方法」から基本的な「センテンス埋め込みの計算」です。

[詳細] (11/23/2022)

Sentence Transformers 2.2 : 事前訓練済みモデル

Sentence Transformers は PyTorch エコシステムの一つで、センテンス、パラグラフや画像に対する密ベクトル表現を計算する簡単な方法を提供するフレームワークです。様々なユースケースに対して調整された 100 言語以上の最先端の事前訓練済みモデルを提供しています。

今回は「事前訓練済みモデル」です。Sentence Transformers は様々な事前訓練済みモデルを提供しており、すべてのモデルは HuggingFace モデルハブにホストされています。

[詳細] (11/24/2022)

Sentence Transformers 2.2 : クイックスタート

Sentence Transformers は PyTorch エコシステムの一つで、センテンス、パラグラフや画像に対する密ベクトル表現を計算する簡単な方法を提供するフレームワークです。様々なユースケースに対して調整された 100 言語以上の最先端の事前訓練済みモデルを提供しています。

Getting Started としてクイックスタートをご覧ください。SentenceTransformers をインストールすれば、使用方法は簡単です。

[詳細] (11/22/2022)

Sentence Transformers 2.2 : 概要

Sentence Transformers は PyTorch エコシステムの一つで、センテンス、パラグラフや画像に対する密ベクトル表現を計算する簡単な方法を提供するフレームワークです。様々なユースケースに対して調整された 100 言語以上の最先端の事前訓練済みモデルを提供しています。

モデルは BERT / RoBERTa / XLM-RoBERTa 等のような transformer ネットワークに基づき、様々なタスクで最先端の性能を実現しています。テキストはベクトル空間に埋め込まれ、類似テキストは近接しコサイン類似度を使用して効率的に見つけられます。

[詳細] (11/22/2022)

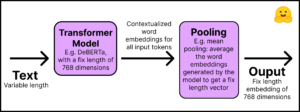

HuggingFace ブログ : 埋め込み (Embeddings) を始める

埋め込み はテキスト, 文書, 画像, 音声等のような、情報のピースの数値表現です。表現は埋め込まれたものの意味論的意味を捉え、多くのアプリケーション利用に対して堅牢にします。

埋め込みはどのように生成されるのでしょう?Sentence Transformers と呼ばれるオープンソース・ライブラリは画像とテキストから最先端の埋め込みを作成することを可能にします。このブログはこのライブラリを使用した例を示します。

[詳細] (11/21/2022)

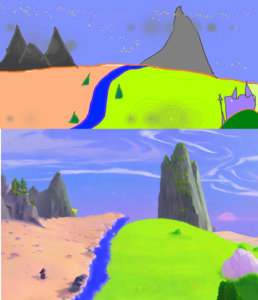

Stable Diffusion Videos 0.6 : ノートブック

Stable Diffusion を使用して潜在空間を探索してテキストプロンプト間でモーフィングすることにより 🔥 動画を作成します。 [詳細] (11/15/2022)

Stable Diffusion Videos 0.6 : 概要

Stable Diffusion を使用して潜在空間を探索してテキストプロンプト間でモーフィングすることにより 🔥 動画を作成します。 [詳細] (11/15/2022)

HuggingFace ブログ : 最初の Decision Transformer の訓練

HuggingFace ブログから「最初の Decision Transformer の訓練」を翻訳しました。Transformer を意思決定モデルとして使用する Decision Transformer の新しいテクニックは段々とポピュラーになっています。今回は half-チーターを走らせる最初のオフライン Decision Transformer モデルをゼロから訓練することを学習します。 [詳細] (11/17/2022)

HuggingFace ブログ : What’s new in Diffusers? 🎨

HuggingFace ブログから「What’s new in Diffusers? 🎨」を翻訳しました。

このブログ記事は diffusers version 0.3 の新機能の高度な概要を与えます!diffusers は拡散モデルのためのモジュール式ツールボックスを提供するライブラリです。Stable Diffusion に対するサポートをリリースしています。

[詳細] (11/14/2022)

HuggingFace ブログ : Stable Diffusion with 🧨 Diffusers

HuggingFace ブログから「Stable Diffusion with 🧨 Diffusers」を翻訳しました。

この記事では、🧨 Diffusers ライブラリ で Stable Diffusion を使用する方法を示し、モデルがどのように動作するかを說明して最後に diffusers が画像生成パイプラインをどのようにカスタマイズを可能にするかを少し掘り下げます。

[詳細] (11/13/2022)

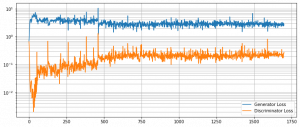

MONAI 1.0 : tutorials : モジュール – MedNIST で GAN

MONAI (Medical Open Network for AI) は PyTorch エコシステムの一部で、医療・ヘルスケア画像における深層学習のための PyTorch ベースのオープンソースのフレームワークです。

今月リリースされた 1.0.1 をベースにドキュメントを翻訳しています。今回はチュートリアルから「MedNIST で GAN」です。このチュートリアルはランダムな入力テンソルから画像を生成するネットワークを訓練するための MONAI の使用方法を示します。単純な GAN は Generator と Discriminator ネットワークから成ります。

[詳細] (11/08/2022)

HuggingFace ブログ : JAX / Flax で 🧨 Stable Diffusion !

HuggingFace ブログから「JAX / Flax で 🧨 Stable Diffusion !」を翻訳しました。🤗 Hugging Face Diffusers はバージョン 0.5.1 から Flax をサポートします!これは Colab, Kaggle or Google Cloud Platform などで利用可能な Google TPU 上で超高速な推論を可能にします。この記事は JAX / Flax を使用して推論を実行する方法を示します。

[詳細] (11/11/2022)

HuggingFace ブログ : Dreambooth による Stable Diffusion の訓練

HuggingFace ブログから「Dreambooth による Stable Diffusion の訓練」を翻訳しました。Dreambooth は再調整の特別な形式を使用して Stable Diffusion に新しいコンセプトを教えるためのテクニックです。この記事は Stable Diffusion を Dreambooth で再調整するとき、貴方の結果を改善するための発見とヒントを提示します。

[詳細] (11/10/2022)

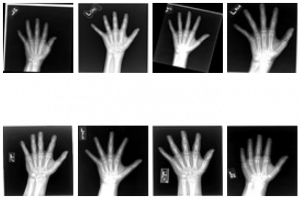

MONAI 1.0 : tutorials : 2D レジストレーション – 2D XRay レジストレーション・デモ

MONAI (Medical Open Network for AI) は PyTorch エコシステムの一部で、医療・ヘルスケア画像における深層学習のための PyTorch ベースのオープンソースのフレームワークです。

今月リリースされた 1.0.1 をベースにドキュメントを翻訳しています。今回はチュートリアルから「2D XRay レジストレーション」です。このチュートリアルは MONAI のレジストレーション機能を紹介するために、学習ベースの 64 x 64 X-Ray ハンドのアフィン・レジストレーションの素早いデモを示します。

[詳細] (11/08/2022)

HuggingFace ブログ : Decision Transformers の紹介

HuggingFace ブログから「Decision Transformers の紹介」を翻訳しました。Decision Transformer モデルは深層強化学習の新しいパラダイムで、強化学習を条件付きシークエンス・モデリング問題として抽象化しています。 “Decision Transformer: Reinforcement Learning via Sequence Modeling” by Chen L. et al. により紹介されました。[詳細] (11/08/2022)

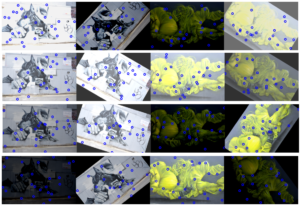

MONAI 1.0 : tutorials : モジュール – MedNIST データセットによる Autoencoder ネットワーク

MONAI (Medical Open Network for AI) は PyTorch エコシステムの一部で、医療・ヘルスケア画像における深層学習のための PyTorch ベースのオープンソースのフレームワークです。

今月リリースされた 1.0.1 をベースにドキュメントを翻訳しています。今回はチュートリアルから「MedNIST データセットによる Autoencoder ネットワーク」です。このチュートリアルは MONAI の autoencoder クラスを実演するために MedNIST ハンド CT スキャン・データセットを使用します。ぼかしやノイズの除去の使用方法として実演します。

[詳細] (11/07/2022)

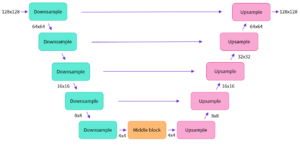

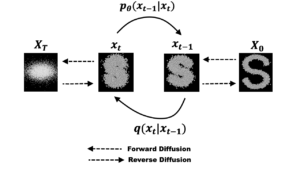

HuggingFace ブログ : 注釈付き拡散モデル

HuggingFace ブログから「注釈付き拡散モデル」を翻訳しました。この記事では、ノイズ除去拡散確率モデル (DDPM) を深く見ていきます。(非) 条件付き画像/音声/動画生成に対して顕著な結果を獲得することができています。ポピュラーな例は OpenAI による GLIDE と DALL-E 2、ハイデルベルク大学による Latent Diffusion、そして Google Brain による ImageGen を含みます。

[詳細] (11/06/2022)

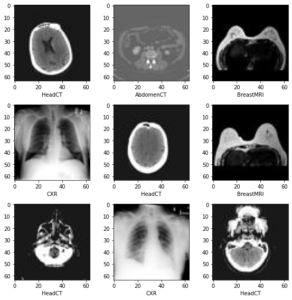

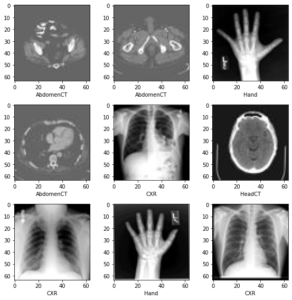

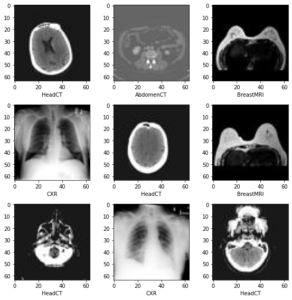

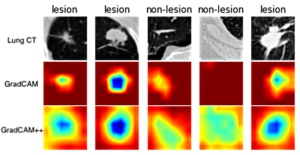

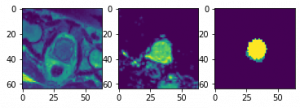

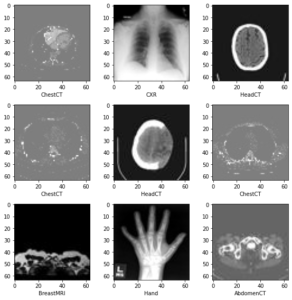

MONAI 1.0 for PyTorch : tutorials : 2D 分類 – MedNIST データセットによる医用画像分類

MONAI (Medical Open Network for AI) は PyTorch エコシステムの一部で、医療・ヘルスケア画像における深層学習のための PyTorch ベースのオープンソースのフレームワークです。

今月リリースされた 1.0.1 をベースにドキュメントを翻訳しています。今回はチュートリアルから「2D 分類 – MedNIST データセットによる医用画像分類」です。このチュートリアルは MONAI 機能を既存の PyTorch プログラムに容易に統合する方法を示します。MedNIST データセットを題材としています、これは初心者のためにチュートリアルとして非常に適切です。

[詳細] (11/02/2022)

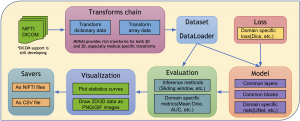

MONAI 1.0 for PyTorch (医用画像処理) : PyTorch ユーザのための MONAI

MONAI (Medical Open Network for AI) は PyTorch エコシステムの一部で、医療・ヘルスケア画像における深層学習のための PyTorch ベースのオープンソースのフレームワークです。

MONAI の設計原理は様々な専門知識を持つユーザのために柔軟で軽量な API を提供することです。総てのコアコンポーネントは独立したモジュールで、これらは任意の既存の PyTorch プログラムに容易に統合できます。

今月リリースされた 1.0.1 をベースにドキュメントを翻訳しています。このチュートリアルは MONAI API を簡単に紹介してその柔軟性と使い易さにハイライトを当てます。MONAI がヘルスケア画像の深層学習のためにドメインに最適化された機能を提供する方法を示します。

[詳細] (11/01/2022)

MONAI 1.0 for PyTorch (医用画像処理) : MedNIST デモ (画像分類チュートリアル)

MONAI (Medical Open Network for AI) は PyTorch エコシステムの一部で、医療・ヘルスケア画像における深層学習のための PyTorch ベースのオープンソースのフレームワークです。

MONAI の設計原理は様々な専門知識を持つユーザのために柔軟で軽量な API を提供することです。総てのコアコンポーネントは独立したモジュールで、これらは任意の既存の PyTorch プログラムに容易に統合できます。

今月リリースされた 1.0.1 をベースにドキュメントを翻訳しています。このチュートリアルでは MedNIST データセットを題材とする画像分類タスクに対して MONAI ベースの end-to-end な訓練と評価サンプルを紹介します。

[詳細] (10/31/2022)

MONAI for PyTorch 1.0 (医用画像処理) : 概要

MONAI (Medical Open Network for AI) は PyTorch エコシステムの一部で、医療・ヘルスケア画像における深層学習のための PyTorch ベースのオープンソースのフレームワークです。

今月リリースされた 1.0.1 をベースに幾つかドキュメントを翻訳します。最初は README を概要として翻訳します。 MONAI の設計原理は様々な専門知識を持つユーザのために柔軟で軽量な API を提供することです。総てのコアコンポーネントは独立したモジュールで、これらは任意の既存の PyTorch プログラムに容易に統合できます。

[詳細] (10/29/2022)

Kornia 0.6 : Tutorials (中級) : 顔検出とぼかし

PyTorch のコンピュータビジョンについて学習するチュートリアルから、今回は顔検出 API を使用し、検出された画像をぼかす方法を示します。

Kornia は PyTorch のエコシステムで、微分可能なコンピュータビジョン・ライブラリです。一般的なコンピュータビジョン問題を解くためのルーチンと微分可能なモジュールのセットから構成されます。

[詳細] (10/29/2022)

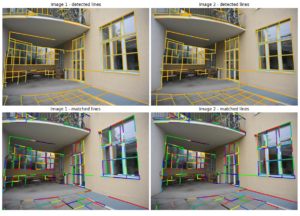

Kornia 0.6 : Tutorials (中級) : SOLD2 によるライン検出とマッチング

PyTorch のコンピュータビジョンについて学習するチュートリアルから、今回は kornia.feature.sold2 API を使用してライン検出、そしてマッチングを素早く実行できる方法を示します。

Kornia は PyTorch のエコシステムで、微分可能なコンピュータビジョン・ライブラリです。一般的なコンピュータビジョン問題を解くためのルーチンと微分可能なモジュールのセットから構成されます。

[詳細] (10/29/2022)

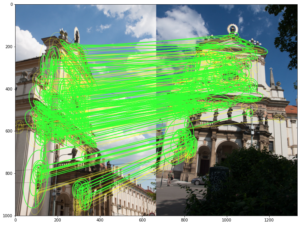

Kornia 0.6 : Tutorials (中級) : KeyNet-AdaLAM による画像マッチング

PyTorch のコンピュータビジョンについて学習するチュートリアルから、今回は KeyNet-AdaLAM による画像マッチングを実演します。最先端のマッチフィルタリングのために kornia を使用します。

Kornia は PyTorch のエコシステムで、微分可能なコンピュータビジョン・ライブラリです。一般的なコンピュータビジョン問題を解くためのルーチンと微分可能なモジュールのセットから構成されます。

[詳細] (10/28/2022)

Kornia 0.6 : Tutorials (中級) : LoFTR による画像マッチング

PyTorch のコンピュータビジョンについて学習するチュートリアルから、今回は最先端のマッチフィルタリングのために kornia を使用します。OpenCV SIFT 特徴量で画像マッチング・パイプラインを定義していきます。

Kornia は PyTorch のエコシステムで、微分可能なコンピュータビジョン・ライブラリです。一般的なコンピュータビジョン問題を解くためのルーチンと微分可能なモジュールのセットから構成されます。

[詳細] (10/27/2022)

Kornia 0.6 : Tutorials (中級) : 幾何学的な画像と点の変換

PyTorch のコンピュータビジョンについて学習するチュートリアルから、今回は幾何学的に合成画像を生成して操作し、2D ポイントを操作するために変換を使用する方法、そしてデータ増強を実行するために torch コンポーネントと組み合わせる方法を学習します。

Kornia は PyTorch のエコシステムで、微分可能なコンピュータビジョン・ライブラリです。一般的なコンピュータビジョン問題を解くためのルーチンと微分可能なモジュールのセットから構成されます。

[詳細] (10/28/2022)

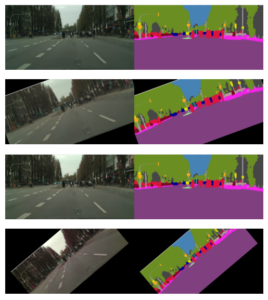

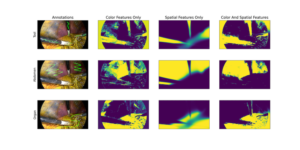

Kornia 0.6 : Tutorials (データ増強) : データ増強セマンティックセグメンテーション

PyTorch のコンピュータビジョンについて学習するチュートリアルから、今回は kornia.augmentation API を使用して、セマンティックセグメンテーションに対してデータ増強を素早く実行できる方法を示します。

Kornia は PyTorch のエコシステムで、微分可能なコンピュータビジョン・ライブラリです。一般的なコンピュータビジョン問題を解くためのルーチンと微分可能なモジュールのセットから構成されます。

[詳細] (10/26/2022)

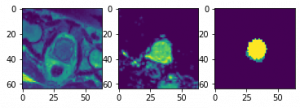

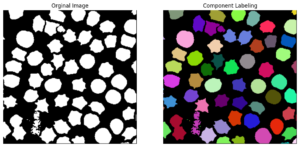

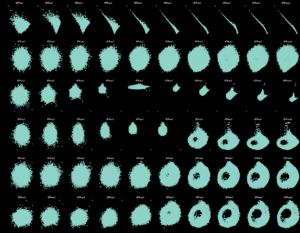

Kornia 0.6 : Tutorials (基本) : 連結コンポーネント・アルゴリズム

PyTorch のコンピュータビジョンについて学習するチュートリアルから、今回は連結コンポーネント・ラベリング (CCL) と呼ばれる古典的なコンピュータビジョン・テクニックの kornia 実装を使用して画像の小さいオブジェクトを分割する方法を学習していきます。

Kornia は PyTorch のエコシステムで、微分可能なコンピュータビジョン・ライブラリです。一般的なコンピュータビジョン問題を解くためのルーチンと微分可能なモジュールのセットから構成されます。

[詳細] (10/26/2022)

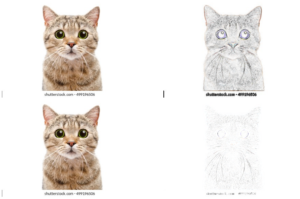

Kornia 0.6 : Tutorials (基本) : Canny 演算子によるエッジの取得

PyTorch のコンピュータビジョンについて学習するチュートリアルから、今回は Kornia を使用して典型的な canny エッジ検出を簡単に適用できる方法を示します。

Kornia は PyTorch のエコシステムで、微分可能なコンピュータビジョン・ライブラリです。一般的なコンピュータビジョン問題を解くためのルーチンと微分可能なモジュールのセットから構成されます。

[詳細] (10/25/2022)

Kornia 0.6 : Tutorials (基本) : unsharp マスクを使用した画像の鮮明化

PyTorch のコンピュータビジョンについて学習するチュートリアルから、今回は unsharp マスクを使用して画像を鮮明化する方法を說明します。

Kornia は PyTorch のエコシステムで、微分可能なコンピュータビジョン・ライブラリです。一般的なコンピュータビジョン問題を解くためのルーチンと微分可能なモジュールのセットから構成されます。

[詳細] (10/25/2022)

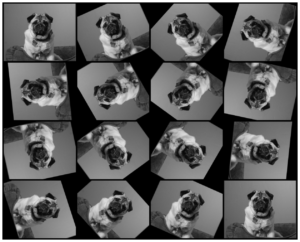

Kornia 0.6 : Tutorials (基本) : ワープアフィン変換による画像回転

PyTorch のコンピュータビジョンについて学習するチュートリアルから、今回は kornia.gemetry コンポーネントを使用して画像を回転する方法を学習していきます。

Kornia は PyTorch のエコシステムで、微分可能なコンピュータビジョン・ライブラリです。一般的なコンピュータビジョン問題を解くためのルーチンと微分可能なモジュールのセットから構成されます。

[詳細] (10/23/2022)

Kornia 0.6 : Tutorials (基本) : 形態学的演算子へのイントロダクション

PyTorch のコンピュータビジョンについて学習するチュートリアルから、今回は kornia.morphology を探索します、これは微分可能な形態学的演算子のための Kornia のモジュールです。

Kornia は PyTorch のエコシステムで、微分可能なコンピュータビジョン・ライブラリです。一般的なコンピュータビジョン問題を解くためのルーチンと微分可能なモジュールのセットから構成されます。

[詳細] (10/23/2022)

Kornia 0.6 : Tutorials (基本) : 画像補正

PyTorch のコンピュータビジョンについて学習するチュートリアルから、今回は kornia.enhance からのコンポーネントを使用して画像特性を調整する方法を学習していきます。

Kornia は PyTorch のエコシステムで、微分可能なコンピュータビジョン・ライブラリです。一般的なコンピュータビジョン問題を解くためのルーチンと微分可能なモジュールのセットから構成されます。

[詳細] (10/21/2022)

Kornia 0.6 : Tutorials (基本) : 色空間

PyTorch のコンピュータビジョンについて学習するチュートリアルから、今回は kornia.color を使用して別の色空間から画像を変換する方法を学習していきます。

Kornia は PyTorch のエコシステムで、微分可能なコンピュータビジョン・ライブラリです。一般的なコンピュータビジョン問題を解くためのルーチンと微分可能なモジュールのセットから構成されます。

[詳細] (10/21/2022)

Kornia 0.6 : Tutorials (基本) : Hello world: Planet Kornia

PyTorch のコンピュータビジョンについて学習するチュートリアルがあります。最初は Torchvision, Kornia と OpenCV で画像のロードを簡単に行なう方法を示します。

Kornia は PyTorch のエコシステムで、微分可能なコンピュータビジョン・ライブラリです。

一般的なコンピュータビジョン問題を解くためのルーチンと微分可能なモジュールのセットから構成されます。コアパッケージは効率性と、複雑な関数の勾配を定義して計算するリバースモードの自動微分を活用するためにバックエンドとして PyTorch を使用しています。

[詳細] (10/20/2022)

Kornia 0.6 : 概要 (README)

Kornia は PyTorch のエコシステムで、微分可能なコンピュータビジョン・ライブラリです。

一般的なコンピュータビジョン問題を解くためのルーチンと微分可能なモジュールのセットから構成されます。コアパッケージは効率性と、複雑な関数の勾配を定義して計算するリバースモードの自動微分を活用するためにバックエンドとして PyTorch を使用しています。

[詳細] (10/20/2022)

HuggingFace Diffusers 0.4 : ノートブック : Stable Diffusion Dreambooth 再調整

Dreambooth により Stable Diffusion に新しいコンセプトを「教える」方法を、🤗 Hugging Face 🧨 Diffusers ライブラリ を使用して示します。

🤗 Diffusers はビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

[詳細] (10/18/2022)

HuggingFace Diffusers 0.4 : ノートブック : Stable Diffusion の Dreambooth 再調整モデルの実行

Dreambooth により訓練された Stable Diffusion コンセプトを、🤗 Hugging Face 🧨 Diffusers ライブラリを使用して、実行することを可能にします。

🤗 Diffusers はビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

[詳細] (10/16/2022)

HuggingFace Diffusers 0.4 : ノートブック : Stable Diffusion の Textual-inversion 再調整

Textual Inversion により Stable Diffusion に新しいコンセプトを「教える」方法を示します。

🤗 Diffusers はビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

[詳細] (10/15/2022)

HuggingFace Diffusers 0.4 : ノートブック : Stable Diffusion Textual Inversion – コンセプトライブラリ・ナビゲーションと使用方法

コンセプトの公開ライブラリをナビゲートして Stable Diffusion をカスタム・コンセプトで使用します。

🤗 Diffusers はビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

[詳細] (10/13/2022)

HuggingFace Diffusers 0.4 : ノートブック : Stable Conceptualizer – 学習済みコンセプトを使用した Stable Diffusion

Stable Conceptualizer (概念化器) は、🤗 Hugging Face 🧨 Diffusers ライブラリを使用して、textual-inversion による Stable Diffusion の事前学習済みコンセプトを使用することを可能にします。

🤗 Diffusers はビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

[詳細] (10/13/2022)

HuggingFace Diffusers 0.4 : ノートブック : Stable Diffusion のインペインティング・パイプライン

このノートブックは、🤗 Diffusers ライブラリを使用して Stable Diffusion モデルによるテキスト-guided インペインティングに対するカスタム diffusers パイプラインを作成する方法を示します。

🤗 Diffusers はビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

[詳細] (10/12/2022)

HuggingFace Diffusers 0.4 : ノートブック : Stable Diffusion の画像-to-画像パイプライン

このノートブックは、🤗 Diffusers ライブラリを使用して Stable Diffusion モデルによるテキスト-guided 画像-to-画像生成に対するカスタム diffusers パイプラインを作成する方法を示します。

🤗 Diffusers はビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

[詳細] (10/11/2022)

HuggingFace Diffusers 0.4 : ノートブック : Stable Diffusion

Stable Diffusion は CompVis, Stability AI と LAION の研究者と技術者により作成されたテキスト-to-画像変換の潜在拡散モデルです。このノートブックでは Stable Diffusion を 🤗 Diffusers ライブラリで使用する方法を紹介します。

🤗 Diffusers はビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

[詳細] (10/11/2022)

HuggingFace Diffusers 0.4 : ノートブック : Diffusers による訓練

今回は「ノートブック」から「Diffusers による訓練」です。拡散モデルが最先端の生成モデルとして王座についたことは明らかです。ここでは単純な拡散モデルを訓練するために Hugging Face のまったく新しい Diffusers ライブラリを使用します。

🤗 Diffusers はビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

[詳細] (10/09/2022)

HuggingFace Diffusers 0.4 : ノートブック : イントロダクション

今回は「ノートブック」から「イントロダクション」です。拡散モデルのための Hugging Face の新しいライブラリ Diffusers をノートブック形式で紹介します。

🤗 Diffusers はビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

[詳細] (10/09/2022)

HuggingFace Diffusers 0.3 : 訓練 : Textual Inversion

今回は「訓練」カテゴリーから「Textual Inversion」です。Textual Inversion は、テキスト-to-画像パイプラインを制御するために後で利用できる方法で、少ない数のサンプル画像から新規の概念を獲得するテクニックです。

🤗 Diffusers はビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

[詳細] (10/08/2022)

HuggingFace Diffusers 0.3 : 訓練 : 条件なし画像生成

今回は「訓練」カテゴリーから「条件なし画像生成」です。このセクションでは、条件なし画像生成拡散モデルをどのように訓練できるかを説明します。

🤗 Diffusers はビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

[詳細] (10/06/2022)

HuggingFace Accelerate 0.12 : Tutorials : Jupyter 環境からのマルチノード訓練の起動

「Tutorials」の「Jupyter 環境からのマルチノード訓練の起動」では、分散システム上の Jupyter Notebook から 🤗 Accelerate でコンピュータビジョン・モデルを再調整する方法を教えます。

🤗 Accelerate は PyTorch モデルの訓練ループを書きたいけれども、マルチ-GPUs/TPU/fp16 に必要なボイラープレートなコードを書いて保守することは避けたい PyTorch ユーザのために作成されました。

[詳細] (10/04/2022)

HuggingFace Accelerate 0.12 : Tutorials : 🤗 Accelerate スクリプトの起動

前のチュートリアルで、🤗 Accelerate を使用するために現在の訓練スクリプトを修正する方法を紹介しました。「Tutorials」の「🤗 Accelerate スクリプトの起動」では、このコードをどのように実行するのか、そして利用可能なハードウェアを活用させる方法を示します。

🤗 Accelerate は PyTorch モデルの訓練ループを書きたいけれども、マルチ-GPUs/TPU/fp16 に必要なボイラープレートなコードを書いて保守することは避けたい PyTorch ユーザのために作成されました。

[詳細] (10/03/2022)

HuggingFace Accelerate 0.12 : Tutorials : 🤗 Accelerate への移行

「Tutorials」の「🤗 Accelerate への移行」では、既存の PyTorch コードを 🤗 Accelerate を使用するためにどのように簡単に変換できるかを詳述します。

🤗 Accelerate は PyTorch モデルの訓練ループを書きたいけれども、マルチ-GPUs/TPU/fp16 に必要なボイラープレートなコードを書いて保守することは避けたい PyTorch ユーザのために作成されました。

[詳細] (10/02/2022)

HuggingFace Accelerate 0.12 : Getting Started : クイックツアー

「Getting Started」の「クイックツアー」では、🤗 Accelerate の主要な機能と回避すべき落とし穴を見てみます。

🤗 Accelerate は PyTorch モデルの訓練ループを書きたいけれども、マルチ-GPUs/TPU/fp16 に必要なボイラープレートなコードを書いて保守することは避けたい PyTorch ユーザのために作成されました。

[詳細] (10/02/2022)

HuggingFace Accelerate 0.12 : 概要

🤗 Accelerate は PyTorch モデルの訓練ループを書きたいけれども、マルチ-GPUs/TPU/fp16 を使用するために必要なボイラープレートなコードを書いて保守することは気乗りしないような PyTorch ユーザのために作成されました。

🤗 Accelerate はマルチ-GPUs/TPU/fp16 に関連するボイラープレートなコードだけを正確に抽象化して残りの貴方のコードは変更しないでそのままにします。

[詳細] (10/01/2022)

◆ 2022/3Q (07/02/2022 〜 09/29/2022)

HuggingFace Diffusers 0.3 : 訓練 : 概要

今回は「訓練」カテゴリーから「概要」です。Diffusers サンプルは様々なユースケースについて diffusers ライブラリを効果的に使用する方法を実演するスクリプトのコレクションです。

🤗 Diffusers はビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

[詳細] (09/30/2022)

HuggingFace Diffusers 0.3 : 最適化 : メモリと速度

今回は「最適化」カテゴリーから「メモリと速度」です。メモリやスピードに対して 🤗 Diffusers 推論を最適化するための幾つかのテクニックとアイデアを提示します。

🤗 Diffusers はビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

[詳細] (09/29/2022)

HuggingFace Diffusers 0.3 : 使用方法 : 推論のためのパイプライン

今回は 🤗 Diffusers の使用方法から「推論のためのパイプライン」です。公式にサポートされている Diffusers パイプラインはタスクベースで各種用意されています。その各々についてその利用方法を簡単に説明します。

🤗 Diffusers はビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

[詳細] (09/29/2022)

HuggingFace Diffusers 0.3 : Getting Started : クイックツアー

今回のクイックツアーでは Stable Diffusion を例に、推論のために DiffusionPipeline をどのように使用するかを紹介します。

🤗 Diffusers はビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

[詳細] (09/28/2022)

HuggingFace Diffusers 0.3 : Getting Started : Diffusers

今回は Getting Started として Stable Diffusion を始めとする、公式にサポートされたパイプラインが紹介されます。9 月に 🤗 Diffusers 0.3 がリリースされ、ドキュメントも大幅に改良されましたので再翻訳しています。

🤗 Diffusers はビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

[詳細] (09/27/2022)

HuggingFace Diffusers 0.3 : 概要

9 月に 🤗 Diffusers 0.3 がリリースされ、ドキュメントも大幅に改良されましたので再翻訳します。最初は README です。🤗 Diffusers は PyTorch のエコシステムで Stable Diffusion も取り込んでいます。

🤗 Diffusers はビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

[詳細] (09/26/2022)

拡散確率モデル (2) イントロダクション

この 2 番目のノートブックでも拡散確率モデルの探求を続けます。

ここでは、前のノートブックで見たスコアマッチングとランジュバン動力学の基本を素早くおさらいします。それから、熱力学に基づく拡散確率モデルのオリジナルの定式化、そしてより最近のノイズ除去の定式化を紹介します。

[詳細] (09/20/2022)

拡散確率モデル (1) スコアマッチング

このノートブックは拡散確率モデルに基づく生成モデルの新しいクラスへの良いガイダンスとなっています。

このクラスのモデルは熱力学からの考察にインスパイアされていますが、ノイズ除去スコアマッチング、ランジュバン動力学と自己回帰デコーディングへの強い類似性もまた持っています。ノイズ除去拡散暗黙モデルの最近の開発についても考察します。

[詳細] (09/16/2022)

ノイズ除去拡散モデル : チュートリアル

これはノイズ除去拡散モデルへの単純なガイドです。foward/逆拡散や損失関数について簡単に説明されています。ノートブック形式で PyTorch 実装です。

[詳細] (09/12/2022)

Stable Diffusion (テキスト-to-画像変換) : 概要

Stable Diffusion は潜在的なテキスト-to-画像拡散モデルです。Google の Imagen と同様に、このモデルはテキストプロンプト上で条件付けるために CLIP テキストエンコーダを使用しています。860M UNet と 123M テキストエンコーダを装備したこのモデルは比較的軽量で少なくとも 10GB VRAM を持つ GPU 上で動作します。

[詳細] (09/11/2022)

潜在拡散モデル (Latent Diffusion Models) : 概要

論文「潜在拡散モデルによる高解像度画像合成」に基づく CompVis による PyTorch 実装です。検索増強 (= Retrieval Augmented) 拡散モデルを中心に多くの事前訓練済みモデルが提供されています。

[詳細] (09/10/2022)

CLIP (対照的言語-画像事前訓練) : 概要

CLIP (対照的言語-画像事前訓練) は様々な (画像, テキスト) ペアで訓練されたニューラルネットワークです。オリジナル実装は PyTorch で OpenAI により公開されました。

GPT-2 と 3 のゼロショット機能と同様にタスクに対して直接最適化されることなく、画像が与えられたとき最も関連性の高いテキストのスニペットを予測するように自然言語で指示できます。

[詳細] (09/09/2022)

DiscoArt 0.12 : 概要

DiscoArt はジェネレーティブ・アーティスト, AI 熱狂者とハードコアな開発者向けの魅惑的な Disco Diffusion アートワークを作成するエレガントな方法です。PyTorch を利用しています。

[詳細] (09/07/2022)

HuggingFace Diffusers 0.2 : Stable Diffusion (テキスト-to-画像変換)

🤗 Diffusers は PyTorch のエコシステムで、ビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

幾つかドキュメントを翻訳しています。今回は「Stable Diffusion」です。Stable Diffusion は CompVis, Stability AI と LAION の研究者と技術者により作成されたテキスト-to-画像の潜在拡散モデルです。

[詳細] (09/01/2022)

HuggingFace Diffusers 0.2 : クイックスタート : diffuser モデルの訓練

🤗 Diffusers は PyTorch のエコシステムで、ビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

幾つかドキュメントを翻訳しています。今回は「クイックスタート」から「diffuser モデルの訓練」です。現時点では拡散モデルが最先端の生成モデルとして王座についたことは明らかです。ここでは、単純な拡散モデルを訓練するために Hugging Face のまったく新しい Diffusers ライブラリを使用します。

[詳細] (08/30/2022)

HuggingFace Diffusers 0.2 : クイックスタート : Getting started

🤗 Diffusers は PyTorch のエコシステムで、ビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

幾つかドキュメントを翻訳しています。今回はクイックスタートから Getting Started です。拡散モデルのための Hugging Face の新しいライブラリを紹介します。

[詳細] (08/28/2022)

HuggingFace Diffusers 0.2 : 概要 (テキストから画像への拡散モデル)

🤗 Diffusers は PyTorch のエコシステムで、ビジョンや音声のような複数のモダリティに対する事前訓練済み拡散モデルを提供し、そして拡散モデルの推論と訓練のためのモジュール型ツールボックスとして機能します。

幾つかドキュメントを翻訳します。最初は README です。

[詳細] (08/24/2022)

ギリシャ語 RoBERTa & GPT2 モデル公開

ギリシャ語 用の以下のモデルを HuggingFace モデルハブで公開しました。データセットは Wikipedia に加えてクロールデータも利用しています。

- RoBERTa モデル [ ClassCat/roberta-small-greek ] – Masked 言語モデル, Fill Mask タスクを遂行できます。 (07/21/2022)

- GPT2 モデル [ ClassCat/gpt2-small-greek-v2 ] – Causal 言語モデル, テキスト生成タスクを遂行できます。 (07/23/2022)

バスク語 RoBERTa & GPT2 モデル公開

バスク語 用の以下のモデルを HuggingFace モデルハブで公開しました。データセットはクロールデータを利用しています。

- RoBERTa モデル [ ClassCat/roberta-small-basque ] – Masked 言語モデル, Fill Mask タスクを遂行できます。 (07/19/2022)

- GPT2 モデル [ ClassCat/gpt2-small-basque-v2 ] – Causal 言語モデル, テキスト生成タスクを遂行できます。 (07/18/2022)

カタルーニャ語 RoBERTa & GPT2 モデル公開

カタルーニャ語 用の以下のモデルを HuggingFace モデルハブで公開しました。データセットは Wikipedia に加えてクロールデータも利用しています。

- RoBERTa モデル [ ClassCat/roberta-base-catalan ] – Masked 言語モデル, Fill Mask タスクを遂行できます。 (07/01/2022)

- GPT2 モデル [ ClassCat/gpt2-small-catalan-v2 ] – Causal 言語モデル, テキスト生成タスクを遂行できます。 (07/15/2022)

ラテン語 RoBERTa モデル公開

ラテン語 用の以下のモデルを HuggingFace モデルハブで公開しました。データセットはクロールデータを利用しています。

- RoBERTa モデル [ ClassCat/roberta-base-latin-v2 ] – Masked 言語モデル, Fill Mask タスクを遂行できます。 (06/21/2022)

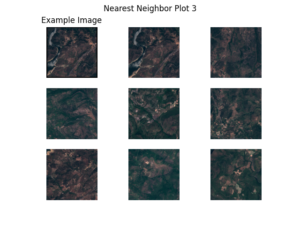

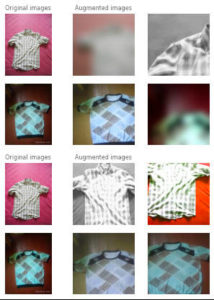

Lightly 1.2 : Tutorials : 4. 衛星画像 上の SimSiam の訓練

Lightly は PyTorch エコシステムの一つで、自己教師あり学習のためのコンピュータビジョン・フレームワークです。ドキュメントを幾つか翻訳しています。

今回は「Tutorials」から「衛星画像 上の SimSiam の訓練」です。このチュートリアルでは、イタリアの衛星画像のセットで従来の PyTorch スタイルで SimSiam モデルを訓練します。

[詳細] (08/21/2022)

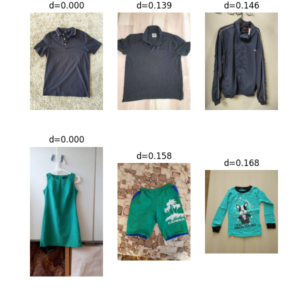

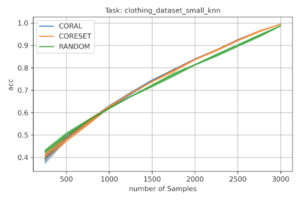

Lightly 1.2 : Tutorials : 3. 衣類データ上の SimCLR の訓練

Lightly は PyTorch エコシステムの一つで、自己教師あり学習のためのコンピュータビジョン・フレームワークです。ドキュメントを幾つか翻訳しています。

今回は「Tutorials」から「衣類データ上の SimCLR の訓練」です。このチュートリアルでは、lightly を使用して SimCLR を訓練します。Alex Grigorev の衣類データセットを使用します。

[詳細] (08/20/2022)

Lightly 1.2 : Tutorials : 2. CIFAR-10 上の MoCo の訓練

Lightly は PyTorch エコシステムの一つで、自己教師あり学習のためのコンピュータビジョン・フレームワークです。ドキュメントを幾つか翻訳しています。

今回は「Tutorials」から「CIFAR-10 上の MoCo の訓練」です。このチュートリアルでは、MoCo 論文「教師なし視覚表現学習のためのモメンタム・コントラスト」に基づいてモデルを訓練します。

[詳細] (08/19/2022)

Lightly 1.2 : Tutorials : 1. 入力の構造化

Lightly は PyTorch エコシステムの一つで、自己教師あり学習のためのコンピュータビジョン・フレームワークです。ドキュメントを幾つか翻訳しています。

今回から「Tutorials」に移行します。最初は「入力の構造化」です。このチュートリアルではフレームワークにより理解されるように画像データセットを構造化する方法を学習します。

[詳細] (08/18/2022)

Lightly 1.2 : 自己教師あり学習の高度なコンセプト

Lightly は PyTorch エコシステムの一つで、自己教師あり学習のためのコンピュータビジョン・フレームワークです。ドキュメントを幾つか翻訳しています。

今回は「Getting Started」から「自己教師あり学習の高度なコンセプト」です。このセクションでは、lightly 周りの幾つかのより高度なトピックを見ます。lightly は主に対照学習法にフォーカスしています。

[詳細] (08/17/2022)

Lightly 1.2 : Getting Started : 能動学習

Lightly は PyTorch エコシステムの一つで、自己教師あり学習のためのコンピュータビジョン・フレームワークです。ドキュメントを幾つか翻訳しています。

今回は「Getting Started」から「能動学習」です。Lightly は数行の追加コードで能動学習を可能にします。アノテートされたデータセットで利用可能な情報を最大化することにより貴方のデータを最大限に活用できます。

[詳細] (08/14/2022)

Lightly 1.2 : Getting Started : 自己教師あり学習

Lightly は PyTorch エコシステムの一つで、自己教師あり学習のためのコンピュータビジョン・フレームワークです。ドキュメントを幾つか翻訳しています。

今回は「Getting Started」から「自己教師あり学習」です。Lightly フレームワークは、最近傍を見つける、類似性検索、転移学習やデータ分析のような幅広い有用なアプリケーションのために利用できます。

[詳細] (08/12/2022)

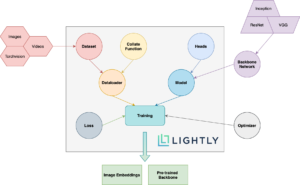

Lightly 1.2 : Getting Started : 主要コンセプト

Lightly は PyTorch エコシステムの一つで、自己教師あり学習のためのコンピュータビジョン・フレームワークです。ドキュメントを幾つか翻訳しています。

今回は「Getting Started」から「主要コンセプト」です。Lightly PIP パッケージにより使用される様々なコンセプトの概要とそれらがどのように相互作用するかのスキーマを説明します。

[詳細] (08/11/2022)

Lightly 1.2 : 概要 (README)

Lightly は PyTorch エコシステムの一つで、自己教師あり学習のためのコンピュータビジョン・フレームワークです。ドキュメントを幾つか翻訳します。最初は README です。

[詳細] (08/10/2022)

PyTorch 1.12 リリースノート

PyTorch 1.12 ステーブル版がリリースされましたので、リリースノートのハイライトを翻訳しておきました。前バージョン (1.11) からおよそ 3ヶ月が経過しています。このリリースは 433 contributors により行なわれた、1.11 からの 3,124 以上のコミットから構成されます。

ハイライトされている機能は多岐に渡ります : 1) TorchArrow, 2) モジュールに対する関数型 API, 3) Complex32 と複素畳み込み, 4) Forward-モード 自動微分, 5) TorchData の DataPipe, AWS S3 統合と Dataloader2, そして 6) functorch があげられます。

[詳細] (07/02/2022)

◆ 2022/2Q (04/02/2022 〜 05/18/2022)

HuggingFace Transformers 4.17 : Notebooks : ゼロからの新しい言語モデルの訓練

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『Notebooks』から「ゼロからの新しい言語モデルの訓練」です。この投稿では、Esperanto 上で “small” モデル (84 M パラメータ = 6 層, 768 隠れサイズ, 12 アテンションヘッド) を訓練する方法を実演します – それは DistilBERT と同じ数の層 & ヘッドです。そして品詞タギングの下流タスクでモデルを再調整します。

[詳細] (05/18/2022)

HuggingFace Transformers 4.17 : Notebooks : 画像分類の再調整

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『Notebooks』から「画像分類の再調整」です。このノートブックは画像分類のための事前訓練済みビジョンモデルをカスタムデータセット上で再調整する方法を示します。

[詳細] (05/13/2022)

HuggingFace Transformers 4.17 : ガイド : 下流タスク用の再調整 – 多岐選択

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『ガイド : 下流タスク用の再調整』から「多岐選択」です。多岐選択タスクは、幾つかの回答候補がコンテキストと一緒に提供される点以外は、質問応答に似ています。モデルはコンテキストが与えられたとき複数の入力から正しい回答を選択するように訓練されています。

[詳細] (05/04/2022)

HuggingFace Transformers 4.17 : ガイド : 下流タスク用の再調整 – 要約

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『ガイド : 下流タスク用の再調整』から「要約」です。要約はドキュメントや記事のより短いバージョンを作成します、これは重要な情報の総てを捉えています。翻訳とともに、それは sequence-to-sequence タスクとして定式化できる別の例です。このガイドは abstractive 要約のための BillSum データセットのカリフォルニア州 bill サブセット上で T5 を再調整する方法を示します。

[詳細] (05/03/2022)

HuggingFace Transformers 4.17 : ガイド : 下流タスク用の再調整 – 翻訳

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『ガイド : 下流タスク用の再調整」から「翻訳」です。翻訳は一つの言語から別の言語にテキストのシークエンスを変換することです。それはビジョンや音声タスクにも拡張できる強力なフレームワークである、sequence-to-sequence 問題として定式化できる幾つかのタスクの一つです。このガイドでは、英語テキストをフランス語に翻訳するために OPUS Books データセットの英-仏サブセット上で T5 を再調整する方法を示します。

[詳細] (05/02/2022)

HuggingFace Transformers 4.17 : ガイド : 下流タスク用の再調整 – 言語モデリング

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『ガイド : 下流タスク用の再調整」から「言語モデリング」です。言語モデリングはセンテンスの単語を予測します。言語モデリングの 2 つの形式があり、このガイドでは Causal 言語モデリング用の DistilGPT2 と Masked 言語モデリング用の DistilRoBERTa を ELI5 データセットの r/askscience サブセットで再調整する方法を示します。

[詳細] (05/01/2022)

HuggingFace Transformers 4.17 : ガイド : 下流タスク用の再調整 – 質問応答

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『ガイド : 下流タスク用の再調整」から「質問応答」です。質問応答タスクは質問が与えられたときに答えを返すものです。このガイドは extractive 質問応答に対して SQuAD データセット上で DistilBERT を再調整する方法を示します。

[詳細] (04/29/2022)

HuggingFace Transformers 4.17 : ガイド : 下流タスク用の再調整 – トークン分類

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『ガイド : 下流タスク用の再調整」から「 トークン分類」です。トークン分類はセンテンスの個々のトークンにラベルを割当てます。最も一般的なトークン分類タスクの一つは固有表現認識 (NER) です。NER はセンテンスの各エンティティに対して、人、位置や組織のようなラベルを見つけようとします。

[詳細] (04/28/2022)

HuggingFace Transformers 4.17 : ガイド : 下流タスク用の再調整 – テキスト分類

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『ガイド : 下流タスク用の再調整」から「 テキスト分類」です。テキスト分類はラベルやクラスをテキストに割り当てる一般的な NLP タスクで、大手企業の幾つかにより広く使用されるテキスト分類の多くの実践的なアプリケーションがあります。このガイドは映画レビューがポジティブかネガティブかを決定するために IMDb データセット上で DistilBERT を再調整する方法を示します。

[詳細] (04/27/2022)

HuggingFace Transformers 4.17 : ガイド : 下流タスク用にモデルを再調整する方法

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『ガイド』から「下流タスク用にモデルを再調整する方法」です。このガイドは一般的な下流タスクに対して HuggingFace Transformers モデルを再調整する方法を示します。データセットを素早くロードして前処理するために HuggingFace Datasets ライブラリを使用し、PyTorch と TensorFlow による訓練のためにそれらを準備します。

[詳細] (04/27/2022)

HuggingFace Transformers 4.17 : ガイド : カスタムモデルの作成

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『ガイド』から「カスタムモデルの作成」です。AutoClass は自動的にモデルアーキテクチャを推測して事前訓練済み configuration と重みをダウンロードします。しかし特定のパラメータに対してより制御を望むユーザは幾つかの基底クラスからカスタム Transformers モデルを作成することができます。このガイドでは AutoClass なしでカスタムモデルを作成する方法を学習します。

[詳細] (04/25/2022)

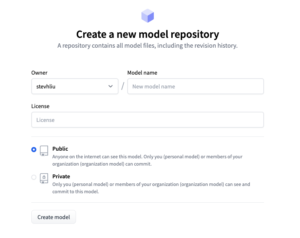

HuggingFace Transformers 4.17 : Tutorials : モデルの共有

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Tutorials』から「モデルの共有」です。Hugging Face は、他の人が時間とリソースを節約するのに役立つように、モデルをコミュニティと共有することを奨励しています。このチュートリアルでは、訓練あるいは再調整されたモデルをハブで共有する 2 つの方法を学習します : (1) プログラミング的にファイルをハブにプッシュする。(2) web インターフェイスでファイルをハブにドラッグ&ドロップする。

[詳細] (04/22/2022)

HuggingFace Transformers 4.17 : Tutorials : 多言語モデル

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Tutorials』から「多言語モデル」です。利用可能な殆どのモデルは単一言語モデルですが、幾つかの多言語モデルが利用可能です。このドキュメントは多言語をサポートするモデル : XML, BERT, XLM-RoBERTa, M2M100 そして MBart を説明しています。

[詳細] (04/21/2022)

HuggingFace Transformers 4.17 : Tutorials : トークナイザーの概要

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Tutorials』から「トークナイザーの概要」です。テキストのトークン化はそれを単語や部分単語に分割します、これらは検索テーブルを通して id に変換されます。単語や部分単語を id に変換することは簡単ですので、テキストを単語や部分単語を分割することにフォーカスします。

[詳細] (04/19/2022)

HuggingFace Transformers 4.17 : Tutorials : 事前訓練済みモデルの再調整

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Tutorials』から「事前訓練済みモデルの再調整」です。このチュートリアルでは、Transformers Trainer, TensorFlow with Keras, そして native PyTorch で事前訓練済みモデルを再調整する方法が紹介されます。事前訓練モデルに使用は大きな利点があります。それは計算コストを削減して、スクラッチから訓練することなく最先端のモデルを利用することを可能にします。Transformers は広範囲のタスクに対して数千の事前訓練済みモデルへのアクセスを提供しています。

[詳細] (04/17/2022)

HuggingFace Transformers 4.17 : Tutorials : モデルの概要

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Tutorials』から「モデルの概要」です。これは HuggingFace Transformers で利用可能なモデルの概要です。個々のモデルは以下のカテゴリーの一つに分類されます :

- 自己回帰モデル

- オートエンコーダ・モデル

- sequence-to-sequence モデル

- マルチモーダル・モデル

- 検索ベースモデル

[詳細] (04/17/2022)

HuggingFace Transformers 4.17 : Tutorials : タスクの概要

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Tutorials』から「タスクの概要」です。このチュートリアルはライブラリを利用するとき頻度の高いユースケースを示します。シークエンス分類、質問応答、言語モデリング、固有表現認識、要約 等々のようなタスクのための使用方法が紹介されます。

[詳細] (04/17/2022)

HuggingFace Transformers 4.17 : Tutorials : 前処理

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Tutorials』から「前処理」です。このチュートリアルでは、以下を行ないます : (1) トークナイザーでテキストデータを前処理する、(2) 特徴抽出器で画像や音声データを前処理する、(3) プロセッサでマルチモーダル・タスクのためのデータを前処理する。

[詳細] (04/15/2022)

HuggingFace Transformers 4.17 : Tutorials : AutoClass による事前訓練済みインスタンスのロード

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Tutorials』から「AutoClass による事前訓練済みインスタンスのロード」です。Hugging Transformers 哲学の一部として、AutoClass はチェックポイントから正しいアーキテクチャを自動的に推測してロードします。このチュートリアルでは、事前訓練済みのトークナイザー, 特徴抽出器, プロセッサ, モデルのロードについて学習します。

[詳細] (04/12/2022)

HuggingFace Transformers 4.17 : Tutorials : 推論のためのパイプライン

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Tutorials』から「推論のためのパイプライン」です。pipeline() 関数はテキスト生成, 画像セグメンテーション, そして音声分類のような様々なタスクに対して、推論のためにモデルハブから適切なモデルを使用することを単純にします。

[詳細] (04/11/2022)

HuggingFace Transformers 4.17 : Get Started : 用語集

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Get Started』から「用語集」です。基本的な一般用語について簡単に説明された後、モデルへの入力について詳述されます。

[詳細] (04/11/2022)

HuggingFace Transformers 4.17 : Get Started : 哲学

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Get Started』から「哲学」です。HuggingFace Transformers の幾つかの目標と主要コンセプトについて説明されます。

[詳細] (04/10/2022)

HuggingFace Transformers 4.17 : Get Started : クイック・ツアー

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Get Started』から「クイック・ツアー」です。テキスト, 画像と音声についてサポートされる主なタスクと、基本的な利用方法である pipeline() と AutoClass (AutoTokenizer, AutoModel) が簡潔に説明されます。

[詳細] (04/09/2022)

HuggingFace Transformers 4.17 : 概要

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

活発にモデルが追加されていますので、4.17 をベースにドキュメントを幾つか翻訳していきます。最初は概要 (README) です。簡単な利用方法と利点、オンラインデモ、モデルのリスト等が説明されます。

[詳細] (04/08/2022)

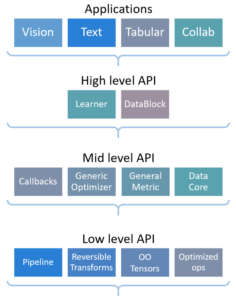

fastai 2.5 : クイックスタート

fastai は PyTorch エコシステムの一つで、現代的なベストプラクティスを使用して高速で正確なニューラルネットの訓練を単純化するライブラリです。

fastai 2.5 をベースにドキュメントを幾つか翻訳しています。今回は「クイックスタート」です。fastai のアプリケーションは総て同じ基本的なステップとコードを使用します。このクイックスタートでは、広範囲な様々なアプリケーションとデータセットでこれらのステップを示します。各ケースのコードは、非常に異なるモデルとデータが使用されるにもかかわらず、極めて類似しています。

[詳細] (04/07/2022)

fastai 2.5 : Welcome to fastai (概要)

fastai は PyTorch エコシステムの一つで、現代的なベストプラクティスを使用して高速で正確なニューラルネットの訓練を単純化するライブラリです。

fastai 2.5 をベースにドキュメントを幾つか翻訳します。最初は “Welcome to fastai というタイトル” の README でインストールも含めた概要が説明されます。

[詳細] (04/06/2022)

PyTorch Ignite 0.4.8 : Tutorials : 事前訓練済み EfficientNet-B0 の再調整

Ignite 0.4.8 をベースにドキュメントを幾つか翻訳しています。今回はチュートリアルから「事前訓練済み EfficientNet-B0 の再調整」です。ImageNet で事前訓練されて CIFAR 100 データセットで再調整された EfficientNet-B0 モデルは 88% テスト精度を与えると報告されています。このチュートリアルではこの結果を Ignite で再現します。

Ignite は PyTorch の公式エコシステムの一つで、PyTorch でニューラルネットワークを訓練するための高位ライブラリです。それは簡潔でありながらフル機能の訓練/評価ループを透過的に書くのに役立ちます。

[詳細] (04/05/2022)

PyTorch Ignite 0.4.8 : Tutorials : Getting Started on Cloud TPU

Ignite 0.4.8 をベースにドキュメントを幾つか翻訳しています。今回はチュートリアルから「Getting Started on Cloud TPU」です。

このチュートリアルでは、まず Colab 上に PyTorch/XLA をインストールして TPU で PyTorch を利用できるようにします。PyTorch/XLA は PyTorch を Cloud TPU に接続させて TPU コアをデバイスとして使用できるパッケージです。そして PyTorch-Ignite で MNIST 上で基本的なモデルを訓練します。

Ignite は PyTorch の公式エコシステムの一つで、PyTorch でニューラルネットワークを訓練するための高位ライブラリです。それは簡潔でありながらフル機能の訓練/評価ループを透過的に書くのに役立ちます。

[詳細] (04/04/2022)

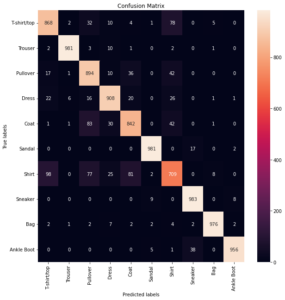

PyTorch Ignite 0.4.8 : Tutorials : Fashion-MNIST の分類のための CNN

Ignite 0.4.8 をベースにドキュメントを幾つか翻訳しています。今回はチュートリアルから「Fashion-MNIST の分類のための CNN」です。このチュートリアルでは Fashion-MNIST データセットを題材とし、畳み込みニューラルネットワークを使用して画像の分類を行なっていきます。ニューラルネットワーク・モデルを訓練し、実験を設定してモデルを検証するために Ignite を使用するチュートリアルです。

Ignite は PyTorch の公式エコシステムの一つで、PyTorch でニューラルネットワークを訓練するための高位ライブラリです。それは簡潔でありながらフル機能の訓練/評価ループを透過的に書くのに役立ちます。

[詳細] (04/03/2022)

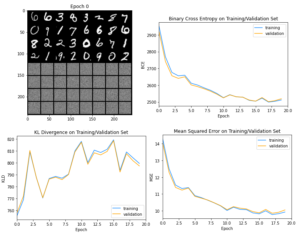

PyTorch Ignite 0.4.8 : Tutorials : 変分オートエンコーダ

Ignite 0.4.8 をベースにドキュメントを幾つか翻訳しています。今回はチュートリアルから「変分オートエンコーダ」です。このチュートリアルでは、Auto-Encoding Variational Bayes by Kingma & Welling を再現していきます。この論文は画像をベクトルにエンコードしてから画像を再構築するためにエンコーダ・デコーダ・アーキテクチャを使用します。

Ignite は PyTorch の公式エコシステムの一つで、PyTorch でニューラルネットワークを訓練するための高位ライブラリです。それは簡潔でありながらフル機能の訓練/評価ループを透過的に書くのに役立ちます。

[詳細] (04/02/2022)

◆ 2022/1Q (01/01/2022 〜 03/30/2022)

PyTorch Ignite 0.4.8 : Tutorials : センテンス分類のための畳込みニューラルネット

Ignite 0.4.8 をベースにドキュメントを幾つか翻訳しています。今回はチュートリアルから「センテンス分類のための畳込みニューラルネット」です。このチュートリアルでは、論文「センテンス分類のための畳込みニューラルネットワーク」(by Yoon Kim) を再現していきます。この論文はテキスト分類に対して CNN を使用していますが、典型的には RNN, ロジスティック回帰, ナイーブベイズに委ねられるタスクです。

Ignite は PyTorch の公式エコシステムの一つで、PyTorch でニューラルネットワークを訓練するための高位ライブラリです。それは簡潔でありながらフル機能の訓練/評価ループを透過的に書くのに役立ちます。

[詳細] (03/30/2022)

einops 0.4 : PyTorch サンプル : pytorch と einops でより良いコードを書く

einops は可読性と信頼性の高いコードのための柔軟でパワフルな tensor 演算です。numpy, pytorch, tensorflow, jax 等をサポートしています。einops は “Einstein-Inspired Notation for operations” (演算のための Einstein-Inspired 記法) を表します。

0.4 をベースに幾つかドキュメントを翻訳します。今回は PyTorch サンプル「pytorch と einops でより良いコードを書く」です。現実的な例で、コードを改良する方法と einops がどのように役立てるかを学習します。単純な畳込みモデルから最新の Transformer モデルまで、深層学習のビルディングブロックを書き直します。これらのコード断片は公式チュートリアルとポピュラーなレポジトリから抜粋されています。

[詳細] (03/29/2022)

einops 0.4 : tutorial part 2 : 深層学習

einops は可読性と信頼性の高いコードのための柔軟でパワフルな tensor 演算です。numpy, pytorch, tensorflow, jax 等をサポートしています。einops は “Einstein-Inspired Notation for operations” (演算のための Einstein-Inspired 記法) を表します。

0.4 をベースに幾つかドキュメントを翻訳します。今回はチュートリアル「2. 深層学習」です。深層学習における einops のユースケースが紹介されます。

[詳細] (03/27/2022)

einops 0.4 : tutorial part 1 : 基本

einops は可読性と信頼性の高いコードのための柔軟でパワフルな tensor 演算です。numpy, pytorch, tensorflow, jax 等をサポートしています。einops は “Einstein-Inspired Notation for operations” (演算のための Einstein-Inspired 記法) を表します。

0.4 をベースに幾つかドキュメントを翻訳します。今回はチュートリアル「1. 基本」です。NumPy を題材にしていますが、他のフレームワークでも同様です。

[詳細] (03/26/2022)

einops 0.4 : 概要

einops は可読性と信頼性の高いコードのための柔軟でパワフルな tensor 演算です。numpy, pytorch, tensorflow, jax 等をサポートしています。einops は “Einstein-Inspired Notation for operations” (演算のための Einstein-Inspired 記法) を表します。

0.4 をベースに幾つかドキュメントを翻訳します。最初は README を「概要」として翻訳しました。

[詳細] (03/25/2022)

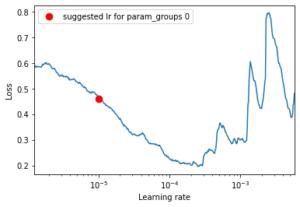

PyTorch Ignite 0.4.8 : How-To ガイド : Ignite で FastaiLRFinder を使う方法

Ignite 0.4.8 をベースにドキュメントを幾つか翻訳しています。今回は「How-To ガイド」から「Ignite で FastaiLRFinder を使う方法」です。このガイドは、モデルを訓練するために最適な学習率を見つけるために FastaiLRFinder ハンドラを活用する方法を実演します。より良い理解のためにこれにより生成された結果とハンドラの使用なしで生成されたものを比較します。

Ignite は PyTorch の公式エコシステムの一つで、PyTorch でニューラルネットワークを訓練するための高位ライブラリです。それは簡潔でありながらフル機能の訓練/評価ループを透過的に書くのに役立ちます。

[詳細] (03/18/2022)

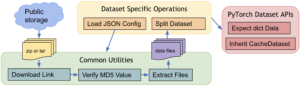

TorchData 0.3.0 Beta : チュートリアル

TorchData は柔軟で高性能なデータパイプラインを容易に構築するために新たに PyTorch に導入されました。Beta 版ではありますが TorchData のドキュメントを幾つか翻訳します。

今回はチュートリアルを翻訳しました。その内容は次の 3 つに分かれています : 1) DataPipe の使用, 2) DataLoader との連携, そして 3) カスタム DataPipe の実装です。

[詳細] (03/16/2022)

TorchData 0.3.0 Beta : 概要

TorchData は柔軟で高性能なデータパイプラインを容易に構築するために新たに PyTorch に導入されました。Beta 版ではありますが TorchData のドキュメントを幾つか翻訳します。最初は README を概要として翻訳しました。

[詳細] (03/15/2022)

PyTorch 1.11.0 リリースノート

PyTorch 1.11 ステーブル版がリリースされましたので、リリースノートのハイライトを翻訳しておきました。前バージョン (1.10) からおよそ 5 ヶ月が経過しています。このリリースは 434 contributors により行なわれた、1.10 からの 3,300 以上のコミットから構成されます。

ハイライトされている機能は : 1) 柔軟で高性能なデータパイプラインを容易に構築するための TorchData, 2) 構成可能な関数変換を PyTorch に追加する functorch, そして 3) 分散データ並列処理 (DDP) の静的グラフの最適化です。

[詳細] (03/13/2022)

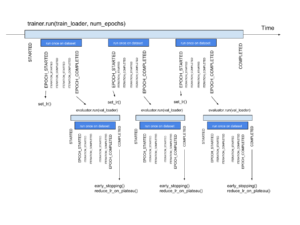

PyTorch Ignite 0.4.8 : How-To ガイド : タイムプロファイリングの方法

Ignite 0.4.8 をベースにドキュメントを幾つか翻訳しています。今回は「How-To ガイド」から「タイムプロファイリングの方法」です。このガイドは以下のような時間分析を得る方法を実演します : * 訓練中の個々のエポック, * 合計訓練時間, * 個々のイベント, *イベントに対応する総てのハンドラ, * 個々のハンドラ, * データロードとデータ処理 等々。

Ignite は PyTorch の公式エコシステムの一つで、PyTorch でニューラルネットワークを訓練するための高位ライブラリです。それは簡潔でありながらフル機能の訓練/評価ループを透過的に書くのに役立ちます。

[詳細] (03/12/2022)

PyTorch Ignite 0.4.8 : How-To ガイド : pure PyTorch コードを Ignite に変換する方法

Ignite 0.4.8 をベースにドキュメントを幾つか翻訳しています。今回から How-To ガイドに入ります。最初は「pure PyTorch コードを Ignite に変換する方法」です。このガイドでは、PyTorch コード・コンポーネントがどのようにコンパクトで柔軟な PyTorch-Ignite コードに変換できるかを示します。

Ignite は PyTorch の公式エコシステムの一つで、PyTorch でニューラルネットワークを訓練するための高位ライブラリです。それは簡潔でありながらフル機能の訓練/評価ループを透過的に書くのに役立ちます。

[詳細] (03/11/2022)

PyTorch Ignite 0.4.8 : AI Tutorials : Ignite による強化学習

Ignite 0.4.8 をベースにドキュメントを幾つか翻訳しています。今回は「Ignite による強化学習」です。このチュートリアルでは、PyTorch-Ignite を使用して、Reinforce と呼ばれるポリシー勾配ベースのアルゴリズムを実装してそれを OpenAI の Cartpole 問題を解くために使用します。

Ignite は PyTorch の公式エコシステムの一つで、PyTorch でニューラルネットワークを訓練するための高位ライブラリです。それは簡潔でありながらフル機能の訓練/評価ループを透過的に書くのに役立ちます。 … [詳細] (03/10/2022)

PyTorch Ignite 0.4.8 : AI Tutorials : T5 モデルによる機械翻訳

Ignite 0.4.8 をベースにドキュメントを幾つか翻訳しています。今回は「T5 モデルによる機械翻訳」です。このチュートリアルは、PyTorch Ignite を使用して機械翻訳モデル (あるいは任意の他の seq2seq モデル) を訓練する方法の簡潔なイントロダクションです。HuggingFace からのモデル, データセットとトークナイザーを利用していて、これらは HuggingFace Hub の他のモデルと容易に置き換えられます。

Ignite は PyTorch の公式エコシステムの一つで、PyTorch でニューラルネットワークを訓練するための高位ライブラリです。それは簡潔でありながらフル機能の訓練/評価ループを透過的に書くのに役立ちます。

[詳細] (03/09/2022)

PyTorch Ignite 0.4.8 : AI Tutorials : CIFAR10 の分散訓練

Ignite 0.4.8 をベースにドキュメントを幾つか翻訳しています。今回は「CIFAR10 の分散訓練」です。このチュートリアルは、 Ignite で 1 つ以上の CPU, GPU or TPU 上で分散訓練を遂行する方法の簡潔なイントロダクションです。幾つかのヘルパー関数と Ignite の概念 (共通の訓練ハンドラのセットアップ、チェックポイントからのセーブ・ロード 等) も紹介します、これらを貴方のコードに簡単に組み込むことができます。

Ignite は PyTorch の公式エコシステムの一つで、PyTorch でニューラルネットワークを訓練するための高位ライブラリです。それは簡潔でありながらフル機能の訓練/評価ループを透過的に書くのに役立ちます。

[詳細] (03/07/2022)

PyTorch Ignite 0.4.8 : AI Tutorials : テキスト分類のための Transformers

Ignite 0.4.8 をベースにドキュメントを幾つか翻訳しています。今回は「テキスト分類のための Transformers」です。このチュートリアルでは、テキスト分類のための Transformers ライブラリからのモデルを PyTorch-Ignite を使用して再調整します。

Ignite は PyTorch の公式エコシステムの一つで、PyTorch でニューラルネットワークを訓練するための高位ライブラリです。それは簡潔でありながらフル機能の訓練/評価ループを透過的に書くのに役立ちます。

[詳細] (03/05/2022)

PyTorch Ignite 0.4.8 : AI Tutorials : Getting Started

Ignite 0.4.8 をベースにドキュメントを幾つか翻訳しています。今回からチュートリアルに入り、最初は Getting Started です。内容的にはクイックスタートに類似していますが、より踏み込んだ内容になっています。

Ignite は PyTorch の公式エコシステムの一つで、PyTorch でニューラルネットワークを訓練するための高位ライブラリです。それは簡潔でありながらフル機能の訓練/評価ループを透過的に書くのに役立ちます。

[詳細] (03/04/2022)

PyTorch Ignite 0.4.8 : コンセプト

Ignite は PyTorch の公式エコシステムの一つで、PyTorch でニューラルネットワークを訓練するための高位ライブラリです。それは簡潔でありながらフル機能の訓練/評価ループを透過的に書くのに役立ちます。

Ignite は 3 つの特徴を提供します : (1) 非常に単純なエンジンとイベントシステム。(2) モデルを容易に評価するための out-of-the-box なメトリクス。(3) 訓練パイプラインを構成し、アーティファクトをセーブしてパラメータとメトリクスをログ記録するための組込みハンドラ。

0.4.8 をベースにドキュメントを幾つか翻訳します。今回は「コンセプト」です。中心的な概念であるエンジンとイベントハンドラについて詳述され、状態やメトリクスについても説明されます。

[詳細] (03/02/2022)

PyTorch Ignite 0.4.8 : クイックスタート

Ignite は PyTorch の公式エコシステムの一つで、PyTorch でニューラルネットワークを訓練するための高位ライブラリです。それは簡潔でありながらフル機能の訓練/評価ループを透過的に書くのに役立ちます。

Ignite は 3 つの特徴を提供します : (1) 非常に単純なエンジンとイベントシステム。(2) モデルを容易に評価するための out-of-the-box なメトリクス。(3) 訓練パイプラインを構成し、アーティファクトをセーブしてパラメータとメトリクスをログ記録するための組込みハンドラ。

0.4.8 をベースにドキュメントを幾つか翻訳します。今回はクイックスタートです。このガイドはプロジェクトを立ち上げて実行するための要点を与えます。

[詳細] (03/02/2022)

PyTorch Ignite 0.4.8 : 概要 (README)

Ignite は PyTorch の公式エコシステムの一つで、PyTorch でニューラルネットワークを訓練するための高位ライブラリです。それは簡潔でありながらフル機能の訓練/評価ループを透過的に書くのに役立ちます。

Ignite は 3 つの特徴を提供します : (1) 非常に単純なエンジンとイベントシステム。(2) モデルを容易に評価するための out-of-the-box なメトリクス。(3) 訓練パイプラインを構成し、アーティファクトをセーブしてパラメータとメトリクスをログ記録するための組込みハンドラ。

0.4.8 をベースにドキュメントを幾つか翻訳します。最初は概要 (README) です。

[詳細] (03/01/2022)

MONAI 0.8 (医用画像処理) : tutorials : 2D 分類 – MedNIST データセットによる医療画像分類

MONAI (Medical Open Network for AI) は PyTorch エコシステムの一部で、医療・ヘルスケア画像における深層学習のための PyTorch ベースのオープンソースのフレームワークです。11 月にリリースされた 0.8.0 をベースに幾つかドキュメントを翻訳しています。

MONAI の設計原理は様々な専門知識を持つユーザのために柔軟で軽量な API を提供することです。総てのコアコンポーネントは独立したモジュールで、これらは任意の既存の PyTorch プログラムに容易に統合できます。

今回はチュートリアルから「2D 分類 – MedNIST データセットによる医療画像分類」です。このチュートリアルは MONAI 機能を既存の PyTorch プログラムに容易に統合する方法を示します。MedNIST データセットを題材としています、これは初心者のためにチュートリアルとして非常に適切です。

[詳細] (01/02/2022)

MONAI 0.8 (医用画像処理) : モジュール概要 (4) 研究, パフォーマンス最適化と GPU 高速化, アプリケーション

MONAI (Medical Open Network for AI) は PyTorch エコシステムの一部で、医用・ヘルスケア画像における深層学習のための PyTorch ベースのオープンソースのフレームワークです。11 月にリリースされた 0.8.0 をベースに幾つかドキュメントを翻訳しています。

MONAI の設計原理は様々な専門知識を持つユーザのために柔軟で軽量な API を提供することです。総てのコアコンポーネントは独立したモジュールで、これらは任意の既存の PyTorch プログラムに容易に統合できます。

今回は「モジュール概要」から「(4) 研究, パフォーマンス最適化と GPU 高速化, アプリケーション」です。MONAI の全体的なアーキテクチャとモジュールが紹介されます。ドキュメントが長いので分割して翻訳しています。

[詳細] (01/01/2021)

MONAI 0.8 (医用画像処理) : モジュール概要 (3) ネットワーク, 評価, ワークフロー 等

MONAI (Medical Open Network for AI) は PyTorch エコシステムの一部で、医用・ヘルスケア画像における深層学習のための PyTorch ベースのオープンソースのフレームワークです。11 月にリリースされた 0.8.0 をベースに幾つかドキュメントを翻訳しています。

MONAI の設計原理は様々な専門知識を持つユーザのために柔軟で軽量な API を提供することです。総てのコアコンポーネントは独立したモジュールで、これらは任意の既存の PyTorch プログラムに容易に統合できます。

今回は「モジュール概要」から「(3) ネットワーク, 評価, ワークフロー 等」です。MONAI の全体的なアーキテクチャとモジュールが紹介されます。ドキュメントが長いので分割して翻訳しています。

[詳細] (01/01/2022)

MONAI 0.8 (医用画像処理) : モジュール概要 (2) データセットとデータローダ

MONAI (Medical Open Network for AI) は PyTorch エコシステムの一部で、医用・ヘルスケア画像における深層学習のための PyTorch ベースのオープンソースのフレームワークです。11 月にリリースされた 0.8.0 をベースに幾つかドキュメントを翻訳しています。

MONAI の設計原理は様々な専門知識を持つユーザのために柔軟で軽量な API を提供することです。総てのコアコンポーネントは独立したモジュールで、これらは任意の既存の PyTorch プログラムに容易に統合できます。

今回は「モジュール概要」から「(2) データセットとデータローダ」です。MONAI の全体的なアーキテクチャとモジュールが紹介されます。ドキュメントが長いので分割して翻訳しています。

[詳細] (01/01/2022)

MONAI 0.8 (医用画像処理) : モジュール概要 (1) 医療画像データI/O, 前処理と増強

MONAI (Medical Open Network for AI) は PyTorch エコシステムの一部で、医療・ヘルスケア画像における深層学習のための PyTorch ベースのオープンソースのフレームワークです。11 月にリリースされた 0.8.0 をベースに幾つかドキュメントを翻訳しています。

MONAI の設計原理は様々な専門知識を持つユーザのために柔軟で軽量な API を提供することです。総てのコアコンポーネントは独立したモジュールで、これらは任意の既存の PyTorch プログラムに容易に統合できます。

今回は「モジュール概要」から「(1) 医療画像データI/O, 前処理と増強」です。MONAI の全体的なアーキテクチャとモジュールが紹介されます。ドキュメントが長いので分割して翻訳しています。

[詳細] (01/01/2022)

MONAI 0.8 (医用画像処理) : PyTorch ユーザのための MONAI

MONAI (Medical Open Network for AI) は PyTorch エコシステムの一部で、医療・ヘルスケア画像における深層学習のための PyTorch ベースのオープンソースのフレームワークです。昨年 11 月にリリースされた 0.8.0 をベースに幾つかドキュメントを翻訳しています。

MONAI の設計原理は様々な専門知識を持つユーザのために柔軟で軽量な API を提供することです。総てのコアコンポーネントは独立したモジュールで、これらは任意の既存の PyTorch プログラムに容易に統合できます。

今回は「PyTorch ユーザのための MONAI」です。このチュートリアルは MONAI API を簡単に紹介してその柔軟性と使い易さにハイライトを当てます。MONAI がヘルスケア画像の深層学習のためにドメインに最適化された機能を提供する方法を示します。

[詳細] (01/01/2022)

MONAI 0.8 (医用画像処理) : MedNIST デモ (画像分類チュートリアル)

MONAI (Medical Open Network for AI) は PyTorch エコシステムの一部で、医療・ヘルスケア画像における深層学習のための PyTorch ベースのオープンソースのフレームワークです。

MONAI の設計原理は様々な専門知識を持つユーザのために柔軟で軽量な API を提供することです。総てのコアコンポーネントは独立したモジュールで、これらは任意の既存の PyTorch プログラムに容易に統合できます。

昨年 11 月にリリースされた 0.8.0 をベースに幾つかドキュメントを翻訳します。このチュートリアルでは MedNIST データセットを題材とする画像分類タスクに対して MONAI ベースの end-to-end な訓練と評価サンプルを紹介します。

[詳細] (01/01/2022)

※ その他、記載されている会社名・製品名は各社の登録商標または商標です。